Статья написана Алексеем Учакиным aka Snake

===========================================

Самая главная транспортная проблема в Питере — это мосты. Ночью из-за них приходится убегать из кабака, не допив пиво. Ну или платить два конца за такси. Утром — тщательно рассчитывать время, чтобы мост уже свели, но ты ещё успел (например — на вокзал). Вариант «ночевать где-нибудь в центре, рядом с вокзалом» мы не рассматриваем, как идеологически вредный.

…«Сапсан», уходящий в 5:30, придумали люди, которые ненавидят сов. Нет, разумеется, очень удобно оказаться в Москве в девять утра, а Питер безумно прекрасен во время белых ночей, но в половину пятого, когда я сел в такси, мне хотелось повернуть голову на 270 градусов тому жаворонку, который придумал этот утренний поезд.

«Все хорошие датацентры похожи друг на друга» — думал я, когда узнал, что нас пригласили в гости ребята из DataLine.

Как оказалось, каждый датацентр хорош (или плох) чуточку по-своему, особенно когда набьёшь шишек, соберёшь все грабли в округе и выучишь уроки из собственного (и, немножечко, чужого) богатого опыта. Вот мы (в составе пяти ведущих linkmeup и примкнувших к ним друзей и сочувствующих) и решили проверить, насколько хороши (или не очень) датацентры OST и NORD.

Успев немного поработать в дороге (тут могла бы быть реклама одного мобильного оператора, но нет — покрытие как было плохим, так и осталось), выгружаемся на Ленинградском вокзале. Ну, хоть не под Газманова.

Начали мы свою экскурсию по «салатовым» ЦОДам с OST — «того самого», который не так давно «горел». Почему в кавычках — после. А пока — стоим, курим, ждём опаздывающих. Фотографируем офис RT по соседству. С этим соседством есть много забавных историй — начиная с укладки свежего асфальта и покраски поребриков бордюров перед приездом Высоких Персон, и заканчивая скидками в окрестных кафешках, которые даталайновцам делали из-за схожести бейджей.

Рупор тоталитарной пропаганды

Датацентр строгого (пропускного) режима

Пропуск, правила поведения, мясорубка на входе — почти такую же мы видели во время экскурсии в Linxdatacenter. А много ли вы видели в ЦОДах кофеен? Мы, вот, теперь парочку знаем. У сотрудников и клиентов на бейджах есть «кофейные» депозиты, которые регулярно пополняются. Так что в разумных пределах кофе можно угоститься совершенно бесплатно. Нас, как дорогих гостей, тоже угостили.

Про кофе не могу сказать ничего плохого — вполне обычно для «сетевой» кофейни, но вот расположение невольно подкупает, а интерьер прямо в лучших современных традициях.

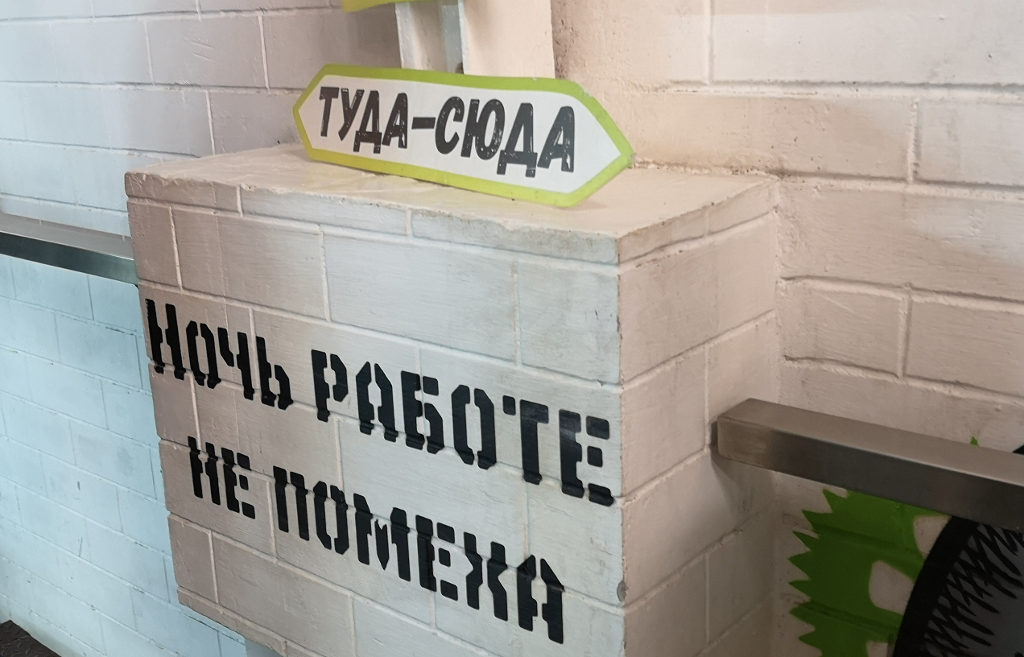

Интерьер местной кофейни

На фотографиях датацентры NORD

Экскурсия начинается с офиса. Помимо известных на весь Рунет надписей на стенах и бело-салатовой гаммы есть ещё и всякие забавные штуки. Это реквизит, оставшийся от выступлений корпоративного театра (вы можете себе представить технического директора сети датацентров, играющего в спектакле? А мы его лично знаем).

И правда

Фотографии со спектаклей

ЦОД (а точнее сказать, четыре ЦОДа) располагаются в комплексе промышленных зданий, построенном ещё в позапрошлом веке (тогда — завод «Ситроён», а во времена СССР — завод «Гидропривод»), так что с одной стороны — тут суровый индастриал, металлические балки, атмосфера лофта и промышленные артефакты разных эпох, которые до сих пор находят при проведении различных работ. С другой — гермозоны ЦОДа нужно вписывать в существующие конструкции, и периодически идти на компромиссы с реальностью. Впрочем, не сказал бы, чтобы эти компромиссы сказались на качестве — но ребятам, наверняка, пришлось попотеть при проектировании. Ещё, по слухам, где-то рядом проходит Метро-2, но это не точно.

Кроме театра здесь есть и свой музей. Экспонаты, натурально — археологические находки

Пару слов о пожаре. Да, здание (а, точнее, крыша) действительно горело. Пострадали внешние блоки систем охлаждения и хладотрассы. Где-то перегорела проводка и кондиционеры остались без электричества. Где-то взорвались фреонопроводы. Но, не смотря на это, гермозоны выдержали тонны вылитой на них воды, оборудование уцелело. Восстанавливали под управлением «штаба» в лице высшего руководства всем миром — выгребли вообще все медные трубки в Москве и окрестностях (привозили даже ночью на BMW X5) и всех трезвых монтажников. Критичное оборудование из пострадавших датахоллов (пострадавших от отсутствия холода, не от пожара) оперативно перенесли по другим залам, так что, уже в пять утра подняли не только все свои сервисы, но и клиентов.

Мы лично проверили тот зал, который больше всего «пострадал» — кроме запаха гари и заменённых плиток фальшпола, о пожаре не напоминает вообще ничего (кроме стоек с оборудованием, «временно» увезённых в другой дата-холл, да там и оставшихся).

Статусная панель

Гуляя по коридорам, видим сенсорный дисплей с чем-то, очень похожим на схему машзалов ЦОДа. Это статусная панель. Их в коридорах натыкано порядком, и они позволяют on-site инженерам быстро найти, например, нужный кондиционер, ну и просто сообщают текущий статус.

Мониторинг построен на Nagios (сейчас уже несколько независимых кластеров) и покрывает все датацентры (и OST, и NORD). Дополнительно есть приложения под Android и iOS (для клиентов и сотрудников), и статусная страница прямо на сайте.

На дисплее замечаю необычно высокий PUE — не везде в России его принято считать, но всё-же 1.90 это несколько много. Ответ на это сугубо экономический — в 2012-2013 годах стойки в ЦОДах расходились, как горячие пирожки, так что было не до сантиментов и энергоэффективности. Ставим то, что есть на рынке, делаем максимально быстро и не заботимся об этих ваших PUE вообще, ибо зачем? Ещё на стадии проектирования выкупается 80-90% стоек, ну а законодательство в РФ про энергоэффективность знать ничего не хочет. Хотя какую-нибудь комиссию в Амстердаме кондратий бы хватил от таких цифр.

Ничего личного. Просто бизнес.

Ещё одна особенность — это маркировка дата-холлов. На каждой площадке дата-холлы помимо «официальной» цифро-буквенной кодировки имеют «человеческие» псевдонимы из военно-морского алфавита (Альфа-Браво-Чарли-Дельта…). Почему-то все клиенты любят зал Whiskey.

В деле заботы о клиентах не бывает мелочей

Такие «заборы» ставят для некоторых клиентов. Нам в машзалах снимать не разрешили, поэтому фото DataLine ©

Клиенты DataLine — сплошь большие и уважаемые компании, они очень не любят, когда фотографируют их оборудование. Тем более, если название (или логотип) клиента написано прямо на стойке крупными буквами. Не любят — и всё тут. Поэтому снимали мы ставшие уже знаменитыми стены с разными надписями, да инженерку. Инженерку фотографировать можно тоже не всю и не везде, но мы старались. Так как среди клиентов — большие и уважаемые, то и запросы у них бывают специфические — специальные стойки (или вообще какая-нибудь убер СХД из нескольких вендорских стоек), свои заборы, свои СКУД, своё видеонаблюдение и группа быстрого реагирования с автоматами. Вообще, одно из негласных (и гласных тоже) правил DataLine — это заботиться о клиенте и делать ему хорошо. Начиная от жилеток и оборудованных рабочих мест с выходом в интернет и зарядками, и заканчивая различными мероприятиями для клиентов. Последние очень полезны ещё и с той стороны, что одни и те же люди, переходя из компании в компанию, приводят их в DataLine. Просто потому, что здесь всё уютно, удобно и надёжно. Бизнес DataLine — это не только сдача стойко-мест. Это ещё и облако, одновременно сертифицированное и по 152-ФЗ и по PCI-DSS (о нём мы собираемся сделать подкаст, следите за анонсами), и предоставление связности (свои волокна между площадками и от каждой из них до М9, своё оптическое кольцо по городу, и так вплоть до организации последней мили к офису клиента).

М — мотивация

К слову, о надписях — идеи приходят не только от сотрудников, но и от партнёров и клиентов, после чего за самые удачные можно проголосовать на официальной странице DataLine в FB. Ну и предложить свою идею можно там же.

Встреча на Эльбе

Кроссовая (фотография предоставлена компанией DataLine)

Останавливаемся у Meet-Me-Room, где располагаются операторы. В MMR (их в OST три пары, по числу магистральных вводов оптики, под активку и пассивку) сводятся подключения со всех дата-холлов. В кроссовой всё скучно и аккуратно. Зато там, где стоит операторская активка, вспоминаешь лучшие годы и кадры с какого-нибудь БМ18: лапша из проводов и разномастное оборудование (DLink, Extreme, Juniper, Mikrotik… и так до ASR9k). Операторов здесь более полусотни, так что всё пёстро. Из MMR оптика и медь расходится по машзалам. Минимум две трассы на каждый (возможны варианты), так что за надёжность подключения можно не переживать. MMR называется «Эльба», что весьма тонко.

IBM Power н-нада?

Ещё одна находка — это IBM P-series, который ни разу не включали, и он уже несколько лет стоит в одном из коридоров. Машину (вместе с ленточной библиотекой и СХД) заказал один из клиентов, но «не пригодилась», поэтому её подарили датацентру. С тех пор и стоит.

Хорошо, наверное, быть состоятельными парнями и делать такие подарки, да? (А может и не подарили, а забыли. Или в карты проиграли. Но стоит давно)

Вот такой красавец стоит в NORD-4

Идём в энергоцентр — три (а то и четыре) ДГУ на каждый ЦОД (напомню, в OST их четыре). Дизель выходит на полную мощность за 30-40 секунд и выдаёт 1900кВА. Резервирование N+1, синхронизация, и прочее — в комплекте. Самое большое время сидения на дизелях в OST — 12 часов. в NORD — 2.5 суток (всё-таки хранилище на 85 тонн это вам не хухры-мухры).

Разумеется, есть договоры с разными топливными компаниями на подвоз топлива. Переключение на дизель происходит регулярно, так что и топливо вырабатывается, и контракты проверяются. К слову, по словам коллег, в NORD при тестировании ДГУ, которое обычно занимает не один час, на месте, куда выбрасывается горячий воздух от дизелей, даже зимой успевает зазеленеть трава.

После короткого перекуса в уже знакомой кофейне едем на площадку NORD. Это тоже не один датацентр, а четыре независимых здания на одной территории. У каждого свои вводы электричества, свои дизели и своё охлаждение. NORD-1 и NORD-2 прошли аудит Uptime Institute M&O. Самый свежий (и самый лучший ЦОД DataLine) — NORD-4, так что идём мы именно сюда.

При огромном, казалось бы, количестве ЦОДов в Москве, всё равно наблюдается дефицит. Нет, конечно, одну-две стойки вам отгрузят без проблем. Даже двадцать дадут. Больше — уже вопрос (а у DataLine клиентов с такими потребностями — не один и не два). Конкретно в NORD-4 место (пока) есть, потому что один крупный клинет съехал в свой собственный свежепостроенный ЦОД, но вот в других местах так может уже не повезти. Тем не менее, сейчас вовсю идёт проектирование NORD-5, который обещают запустить в начале 2020 года.

Но вернёмся к нашей экскурсии. Так как ехали мы на машине, то нас запустили в шлюз, ~~в котором нас взяли на прицел автоматчики~~ номер нашей машины сверили с заявкой, а всех пассажиров попросили выйти для получения пропусков (разумеется, по паспорту). Ибо Б — безопасность.

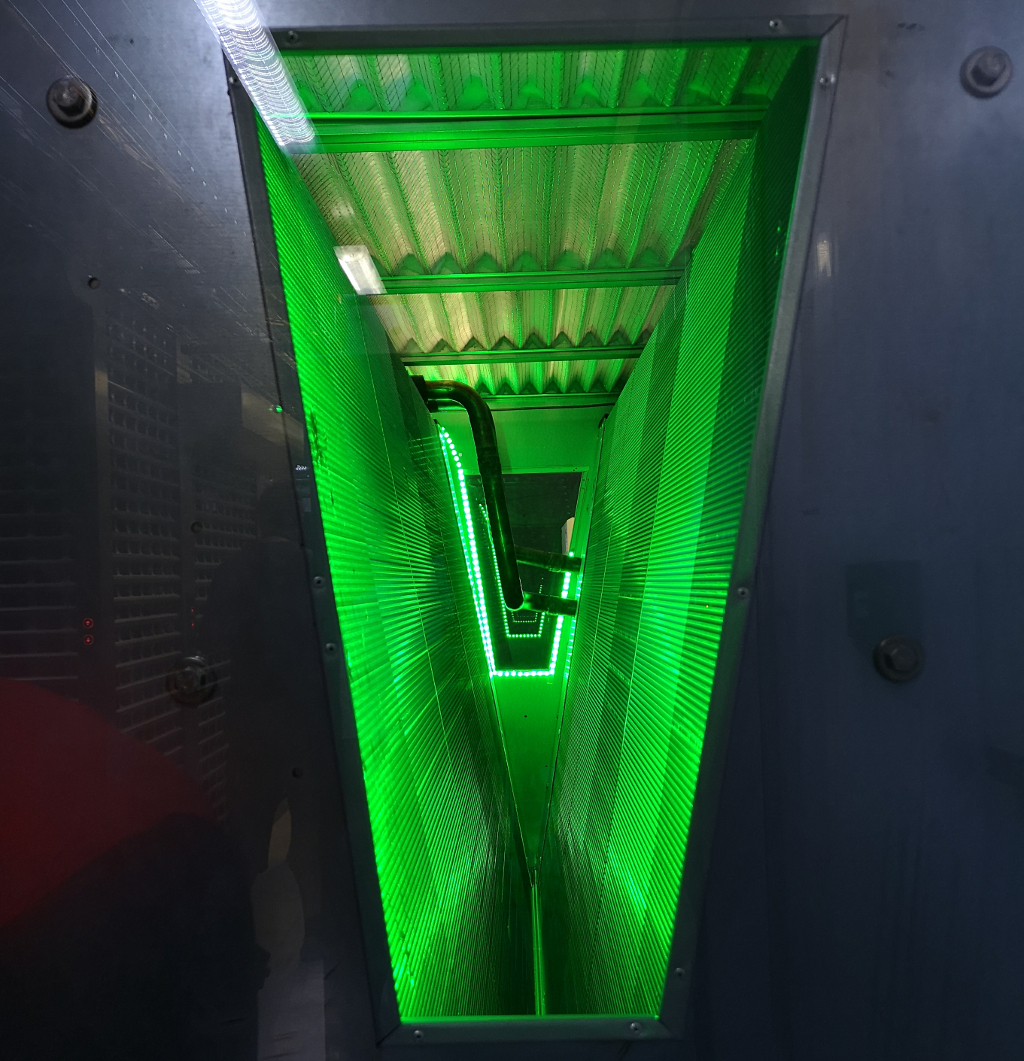

NORD-4 — это гордость компании и компиляция многолетнего опыта в строительстве и эксплуатации датацентров, он имеет сертификаты Uptime Institute Tier III на дизайн-проект и Facility (т.е. построенный ЦОД), а так же Operational Sustainability — ребята к делу подошли максимально ответственно. Внутри — четыре независимых друг от друга гермозоны по два зала внутри одного здания. У каждой — свой энергоцентр (ДГУ, аккумуляторные комнаты) контуры охлаждения и системы пожаротушения. Общего — вводы оптики (их два на здание) и MMR.

Моддинг здорового инженера

На входе в ЦОД ждёт уже знакомая нам кофейня (ну а почему бы и нет?). Поднимаемся в центр мониторинга. Главных сейчас два — в OST и NORD-4 (в NORD-1,2,3 тоже сидят свои дежурные смены). Из каждого центра можно смотреть за обеими площадками, так что даже здесь обеспечивается redundancy n+1. На видеостене — уже знакомые нам дашборды в салатовой гамме (параметров на ней, понятно, гораздо больше, чем на статусном дисплее). Немного общаемся за мониторинг — никаких модных прометеусов и графан, только Nagios, только хардкор и самописная визуализация. За десять лет (впрочем, даже больше) использования написано уже множество кастомных проверок и скриптов, так что съезжать на что-то другое выглядит той ещё авантюрой. Примерно раз в месяц появляется очередная компания, которая предлагает «быстро и безболезненно» решить все проблемы, но пока как-то не складывается. Видеостена, кстати, тоже работает на самосборном решении, которое получилось в разы дешевле коммерческих аналогов.

Здешний ЦУП

Когда много лет проектируешь, строишь и эксплуатируешь датацентры, то уже не так сильно боишься делать что-то сам, а не покупать готовое. DataLine, например, не стесняется говорить, что они, просто за счёт масштаба, наступили на максимальное количество граблей, и каждый новый ЦОД — это сын ошибок трудных и опыта, который насчитывает уже более десяти лет. Разумеется, в каждом новом ЦОДе есть свои ноу-хау, и, гуляя по NORD, то и дело ловишь себя на мысли, то люди просто взяли, и сделали хорошо. Не понта ради, не ради рейтингов и сертификатов — обычный инженерный процесс, когда на каждой итерации ты растёшь над собой и становишься всё лучше и лучше. Сторонний наблюдатель скажет, что это скучно и консервативно, а вот клиент, наоборот, поддерживает такую стабильность собственными деньгами. И для того, чтобы сделать хорошо, совсем не обязательно покупать инженерные системы или софт за много-много денег (хотя и без этого, порой, никак). Чаще решает опыт, знания и инженерная смекалка.

Например, здание NORD-4 насчитывает 3,5 этажа. Первые три — полноценные, с потолками в 4.5 метра, где располагаются машзалы. А последний — технический, высотой всего 1.8 метра, и отдан чисто под систему охлаждения. Так как этаж технический, то и требования к нему гораздо ниже, что позволило упростить проект и сэкономить деньги.

Вид на треугольный ЦОД

Макс обладает особым кунг-фу не палиться на фотках

Завершаем экскурсию на крыше — отсюда открывается отличный вид на стоящую рядом ТЭЦ и жилой массив, а так же на другие здания NORD. Два из них треугольные. По этому поводу коллеги даже смеялись, что «DataLine — дебилы, строят зачем-то треугольный ЦОД» Чтобы ставить там треугольные стойки и треугольные серверы. Но ничего — построили и успешно эксплуатируют, а заодно эффективно используют имеющуюся территорию (которая в Москве, надо сказать, не бесплатная). Ещё один удивительный (для меня) факт — большинство коммерческих клиентов хочет размещаться именно в Москве. Площадка за полста километров по Минскому шоссе (даже если есть все необходимые мощности и коммуникации) уже мало кому интересна. Вот и ютятся все в нерезиновой.

Градирни — это уже не ЦОД, а ТЭЦ

На этом наше очередное путешествие подошло к концу.

После была ещё долгая и продуктивная беседа о совместных планах и будущих подкастах (надеюсь, долго ждать не придётся), так что следите за новостями, скоро будет ещё больше интересного.

Ну а желающих увидеть всё своими глазами DataLine приглашает на экскурсию. Совершенно бесплатно, но по предварительной записи. Тем, кто назовёт кодовое слово «linkmeup» — плюс в карму.

Stay tuned!

0

0

7096

7096

0

0

Ещё статьи

0 коментариев